磁區

既然FreeNAS®

系統磁碟空間,僅能作為系統安裝之用並無法提供任何

NAS(network-attached

storage),故你必須額外配置一個以上的磁區,本系統支援 UFS and ZFS 磁區,建議採用ZFS可提供更廣泛的功能。

註:FreeNAS

儲存磁區稱之為pool

,當你使用圖形界面配置ZFS

資源池時,volumn

的術語習慣稱之為UFS

磁區 or

ZFS 資源池

適當的儲存設計對NAS甚為重要,建議讀者在配置儲存磁碟環境前應澈底閱讀本章,如此方可澈底閱讀所有的可用功能,知道哪些對你的設定最有利,並確知任何警告或硬體的限制。

目錄

|

自動搜索磁區

如按下

儲存 → 磁區 → 自動搜索磁區

可以使用現有的軟體 UFS

或 ZFS

RAID

磁區。此行為一般用於現存系統重新安裝(非升級之用)。既然作業系統與磁碟分離,新的安裝並不影響磁碟中之資料;無論如何,新作業系統應重新使用於現存的磁碟。

可支援的磁區類型有

UFS GEOM

stripes (RAID0), UFS GEOM mirrors (RAID1), UFS GEOM RAID3以及已存在的ZFS

資源池。因為UFS

RAID5有一個未經維護的編碼專案並未整合進FreeBSD

,故不建議使用

。

8.3.1版開始,支援

已存在的 GELI-encrypted

ZFS資源池,惟該資源池在匯入前應予解密。

Figure

6.3顯示

選用自動搜尋磁區時的初始彈出視窗。

Figure

6.3a:安裝自動搜尋磁區畫面

若匯入者為UFS

RAID 或

已存在的非加密 ZFS

資源池,請選

"No:

Skip to import" 後進入存取

Figure

6.3b的畫面。

Figure

6.3b: 自動搜尋非加密磁區

已存在的軟體

RAID磁區應可見於下拉式選單中。Figure

6.3b範例中,

FreeNAS®系統該範例有已存在的非加密磁區,一旦選定磁區,按下"確定"鈕匯入磁區

FreeNAS®無法匯入

dirty

磁區。若現存的UFS

RAID 無法顯示於下拉選單中,必須對該磁區執行fsck。若

若現存的ZFS

資源池

無法顯示於下拉選單中, 由 Shell 中執行zpool

import

以匯入資源池

註:FreeNAS®無法匯入問題磁區,如現存的

UFS

RAID未能顯現於下拉選單,你需要對磁區執行fsck。若果存在

ZFS

資源池未顯示於下拉選單中,由命令列中執行

zpool

import以匯入磁區。如果磁碟未能出現,檢查該磁碟的控制器是否支援或需使用可調參數因應。

若計畫自其它系統中實際安裝

ZFS格式磁碟,於匯入期間請確認在系統中匯出裝置,以避免發生"in

use by another machine"的錯誤。

自動匯入

GELI-Encrypted

ZFS 資源池

如需匯入已存在的

GELI-encrypted

ZFS 資源池,必須先解除加密。(於

Figure

6.3a選用“Yes:

Decrypt disks”,進入

Figure

6.3c畫面)

Figure

6.3c: 匯入ZFS資源池前加密磁區前應先解密

在加密的資源池中選取目標磁碟,瀏覽到金錀保存的位置,輸入該金錀的通關密語後,按下OK鍵即可。

一旦資源池完成解密,即可出現於

Figure

6.3b的下拉選單中。按下OK鍵完成磁區匯入。

匯入磁區

Figure

6.3d顯示的

磁區 → 匯入磁區

瑩幕,係用於匯入符合檔案系統格式的單一磁碟或磁區。FreeNAS®可支援

UFS,

NTFS, MSDOS, or

EXT2.經格式化的單一硬碟或磁區。匯入意味著是一項為了由一個磁碟複製資料到某一磁區的臨時措施。一次只能匯入一個磁碟

Figure

6.3d: 匯入磁區

輸入磁區名稱,可用下拉選單中選取欲匯入的磁碟或磁區,並於檔案系統中選定所需格式。

匯入磁碟前應瞭解以下注意事項:

- FreeNAS®無法匯入dirty檔案系統,若可支援的檔案系統並未出現於下拉式選項中,應於該磁碟執行fsck指令或執行磁碟檢查。

- 現今版本尚無法匯入動態NTFS ,後續版本或可解決這個問題。

- 若NTFS磁區不導入系統,嘗試由Windows 系統中安全的移出該磁區。如此將可修復某些需要被掛載裝置之日誌檔

UFS 磁區管理

雖然可支援USF檔案系統,但卻無法提供譬如壓縮、加密、覆寫、寫入時複製

、輕量快照或提供早期偵測及損壞的數據校正的能力。若你使用USF作為一種暫時性的解決方案直到可以負擔更好的硬體時。請注意你將需要摧毀現存的USF

磁區以重新建立ZFS

pool ,然後回存備份資料。

若有未格式化之磁碟或想覆蓋磁碟中的檔案系統(及資料),可使用磁區管理將目標碟格式成

UFS

磁區或

ZFS

資源池

註:不建議建立

大於5

TB 的USF

磁區(執行

fsck

效率低下),若系統未能關機清理,將導致系統開機時的長時間延宕狀態。

格式化

USF

磁碟,可前往

儲存 → 磁區 → UFS

Volume Manager (legacy) 畫面如

Figure

6.3e.

Figure

6.3e: 建立

UFS

磁區

Table

6.3a 可用選項一覽表.

Table

6.3a: 建立UFS磁區的選項

| Setting | Value | Description |

Volume

name

|

string

|

|

Member

disks

|

list

|

在可用磁碟列以高亮度標示,選定所需磁碟數量

|

| Specify custom path | checkbox | 選項; 用於建立持續保存日誌紀錄的儲存區( /var ) |

| Path | string |

僅用於指定客製化路徑,勾選時必須使用磁區之完整名稱(例如/mnt/var)

。若未標示路徑,將附上磁區名到

/mnt

(例如/mnt/Volumnname)

|

新增磁區按鈕警告”creating

a volume destroys all existing data on selected disk(s)”換言之,建立使用UFS

Volume Manager

是對該選定磁碟的重新格式化行動。若並不想覆寫現存磁區的資料,且該磁區格式支援自動搜尋 auto-import 或匯入 import 行動者。可改採上述兩項方式執行之。若現有儲存格式並不支援,應備份該資料到外部媒體,格式化磁碟,然後回存資料到新的磁區。

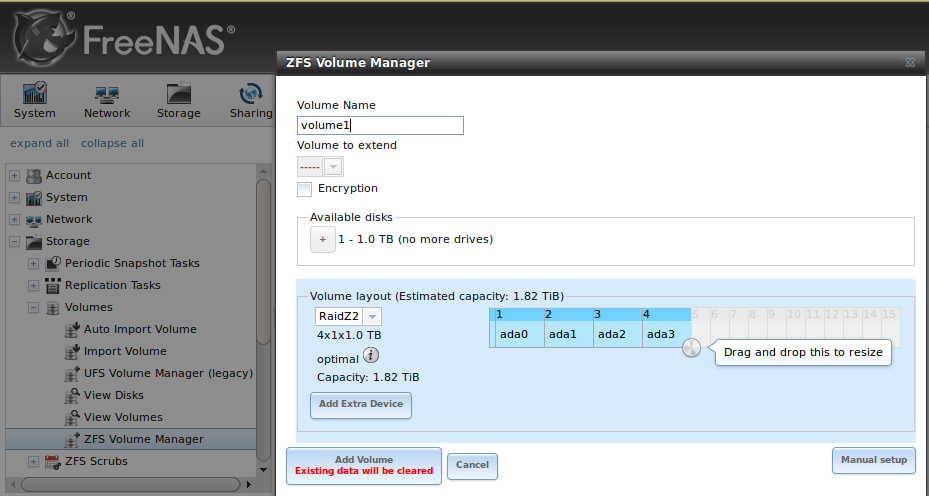

ZFS Volume Manager

若你擁有尚未格式化的磁碟或想對系統上的檔案系統(及資料)加以覆寫,可使用

ZFS

Volume Manager 格式化後加入

ZFS

資源池中。

若按下

儲存 → 磁區 → ZFS

Volume Manager,可見到類似

Figure

6.3f的畫面

Figure

6.3f: 使用

ZFS

Volume Manager建立

ZFS

Pool

Table

6.3b: 建立ZFS

Pool的選項

| Setting | Value | Description |

| Volume name | string | |

| Volume to extend | drop-down menu | 需要現存的ZFS 資料池方式擴充。參閱 Extending a ZFS Volume |

| Encryption | checkbox | 選用加密前請閱讀 Encryption |

| Available disks | display |

顯示可用磁碟的大小;將滑鼠懸停其上會列出可用的設備名

|

| Volume layout | drag and drop |

按下並拖曳圖示去選定需求的磁碟數量

|

| Add Extra Device | button | 在資源池建立期間選擇設定多個資源池或新增日誌或快取裝置 |

拖曳圖示去選定需求的磁碟數量,以建立資源池。

ZFS

Volume Manager

將自動選擇最佳設定並產生儲存容量,用於交換區者,亦將顯示之。若想變更配置或磁碟數量,使用滑鼠拖曳該滑桿到需求磁區配置。下拉選單顯示最佳設定亦可按下變更設定按鈕,倘若設定值不恰當,GUI將轉為紅色。

註:為了效能及容量理由,此瑩幕之操作將不允許採用不同大小的磁碟建立磁區。若需採用不同容量之磁碟建立磁區,仍可使用“Manual

setup”按鈕然後依 Manual

Volume Creation

指引建立磁區,惟系統不建議使用此方式。

按一下提示工具圖示以存取到此文檔的連結

ZFS

Volume Manager

允許存入某一個非最佳化設定。它仍可工作,但效能將低於一個最佳化的設定。此外,若選取的磁碟數量不足建立該設定型態需求數,GUI將不允許選用之。

按下 此工具

頂端圖示以存取此類文件鏈結。

該Add

Volume 按鈕

警告 creating

a volume destroys any existing data on the selected

disk(s).換言之,建立新磁區等同於重新格式化選用之硬碟。若你意圖並非於現存磁區中覆寫資料,看看由

theauto-import or import actions中支援的磁區格式。若是如此,執行該支援行動替代之,若現有之儲存格式未被支援,你將需要備份資料到外部媒體,格式化硬碟,然後回存備份資料到新磁區。

ZFS

Volume Manager 將自動選用最佳方式配置新

pool,均依選用之磁碟數量而定。下列各項即為受支援之格式。

- Stripe: 至少需要一顆磁碟

- Mirror: 至少需要二顆磁碟

- RAIDZ1: 至少需要三顆磁碟

- RAIDZ2: 至少需要四顆磁碟

- RAIDZ3: 至少需要五顆磁碟

- log device: 新增一專用 日誌裝置 (slog)

- cache device: 新增一專用 快取裝置

若你擁有超過5顆的硬碟並使用

ZFS,考量硬碟數量以求得效能及擴充能力。各種

RAID

層級的全覽及建議磁碟群組可於 RAID

Overview 章節中翻閱。更多有關於日誌及快取裝置亦可於 ZFS

Overview 章節中查閱。

根據磁碟的數目與容量,控制器的型式及加密選用與否,磁區之建立將花費些許時間。一但磁區建立,此瑩幕將刷新且新磁區亦將列示於

儲存 → 磁區.

下

加密

- 此非Oracle ZFSv30中使用的加密方法。該版本的ZFS不屬開源碼,仍為甲骨文公司財產

- 全磁碟加密非個別檔案系統加密。底層磁碟最先加密,然後資源池可於其上層另行加密。

- 此加密型式最初目標係用於存放敏感性資料並保有由資源池中移除磁碟無需抹除磁碟內容的能力。

- 此設計適用於獨立加密密鑰的磁碟安全處置,由於只要金錀和磁碟完整,系統很容易解密。故金錀應受強健密碼保護,任何備份金錀亦應安全存放。

- 換言之,若金錀遺失,磁碟中之資料將無法存取。金錀一定要備份!重要通知:若 per-drive GELI 主要金錀未隨著用戶金鑰備份。即使磁碟已加密到最後區段卻發生一個位元的錯誤,此即意味著;磁碟資料將完全遺失(除非該問題已解決)。故詳讀 this forum post 中解釋如何手動備份主要金錀至關重要。 This forum post 對多種採用 GELI 金錀類型的備份方式提供深入解釋。為追蹤此議題的後續進展,請參考 this bug report.

- 密錀僅用於單一ZFS磁區(資料池),如需建立多個資源池,每個資源池均應擁有各自金錀。

- 系統磁碟為數眾多情形下,若CPU尚未支援 AES-NI ,將會產生效能衝擊。無硬體加速下對單一磁碟將有20%的效能衝擊。當磁碟數更多時,效能降級將持續增加。資料寫入時自動加密,讀取時將如飛行速度般解密。若處理器不支援 AES-NI指令集(少數情形),使用加密時解密性能將會降低。(此 forum post 比較各種CPUs 的效能)

- ARC 快取及RAM中的資料業均已解密。

- 即便使用未加密磁區,交換磁區中資料仍為加密狀態。

- 無法轉換已存在未加密磁區。取而代之的是,資料應予備份,摧毀現有的資源池,建立新的加密資源池,再還原備份資料到新加密磁區中。

- 不支援混合資源池,換言之,新建的 vdevs 必須符合現存的加密腳本。當 extending a volume時,磁區管將自動將新的 vdev予以加密,並附加於已存在的資源池中。

註:此加密設施係由FreeNAS®設計以保護磁碟的實體竊取。它並無法保護違反未經授權的軟體存取。若有敏感性的資料存於該系統中應確保僅有已授權的使用者才可以存取管理者GUI並設定適當的共享權限。

建立一個加密的磁區.

欲建立加密磁區,勾選

Figure

6.3f中"Encryption"選項,輸入磁區名稱選取該磁碟新增到磁區中,然後按下Add

Volume 按鈕

以產生該加密磁區。

磁區一旦建立,極為重要的是在金錀上設定通關密語,備份金錀然後建立復原金錀,未依此規,一會兒或許你需要重新匯入磁區了。

執行此類工作,

前往 儲存 → 磁區 ->

檢視

磁區,畫面如 Figure

6.3o

在金錀上設定通關密語,按下該磁區名稱然後"Create

Passphrase"按鈕(錀匙形狀的圖示位於

Figure

6.3o的最右邊),後系統將出現輸入並確認密碼之提示,不像密碼,通關密語可以包含空格,通常是一個文字串。一個好的密碼很容易記住(如一首歌曲或文學作品的一行),且難以猜測(即便認識你的人也不能猜到的通關密語)

當設定密碼時,警告訊息會提醒你建立一個用於金錀復原的通關密語。此情形下,假使原有之通關密語遺失,亦可使用此金錀替代之。建立恢復密鑰,單擊“"Add

recovery key"按鈕(Figure

6.3o 中倒數第二項)。此畫面會提示保存金錀的位置。注意該復原金錀係存於客端系統,而非存於

FreeNAS®

系統。

最後,下載加密密鑰的副本,使用"Download

key"按鈕(Figure

6.3o 的第二行的第一鑰匙圖示)。再一次強調,金錀係存於客端系統,而非存於

FreeNAS®

系統中。

當你使用FreeNAS®

管理

GUI

選用該目錄時,系統將提示輸入先前設定的密碼。

通關密語、復原金錀及密錀均應加以保護。不應洩漏給其它人。包含下載的金錀的系統,該系統及其備份均應受到保護照顧。任何擁有金錀之人均有能力重新匯入磁碟

手動建立磁區

"Manual

Setup" 按鈕可用於建立非最佳化的ZFS磁區(如

Figure

6.3f),惟並不推薦使用。可使用的情

例如 採用不同容量的磁碟或置入多於建議數量的磁碟到某一個vdev

時,建立磁區之用。

註:使用不同容量磁碟時,該磁區將受限於最小磁碟的容量。對某一vdev

使用多於建議數量,超過磁盤的允許數目時,重新同步時間與重新同步完成前的失敗風險必然增加。基於此理由,在此建議採用

ZFS

Volume Manager 建立最佳化

pool ,亦請參閱 ZFS

Volume Manager 內容,並使用相同容量磁碟。

Figure

6.3g 展示 "Manual

Setup" 瑩幕而

Table

6.3c 為可用選項一覽表

Figure

6.3g: 建立非最佳化的

ZFS

Volume

Table

6.3c: Manual Setup Options

| Setting | Value | Description |

| Volume name | string | |

| Encryption | checkbox | 選用加密前請閱 Encryption 章節 |

| Member disks | list | 由可用磁碟列表中以光棒選取需求磁碟數量 |

| Deduplication | drop-down menu | |

| ZFS Extra | bullet selection |

用於指定磁碟用途是用於存儲("None"),日誌,高速快取設備或備用

|

擴充 ZFS 磁區

“Volume

to extend”下拉式選單於

儲存 → 磁區 → ZFS

Volume Manager ,顯示如

Figure

6.3h,可於現存的ZFS磁區中,附加新增磁碟。若系統中並無ZFS磁區,該下拉選單將不顯示。

Figure

6.3h: 擴充磁區功能的欄位

一旦由下拉選單中選取現存磁區,拖拉至需求數量然後選取磁區配置,你可依此例

- 選用一個SSD或磁碟作為 Log (ZIL) 的配置磁區附加到ZFS pool,選用2個 SSD 或磁碟作日誌裝置的鏡像

- 選用SSD或磁碟 Cache (L2ARC) 的磁區配置以增加快取裝置到ZFS pool 中。

- 新增附加磁碟增加ZFS pool的容量。執行注意事項敘述如下:

當新增磁碟到現行的ZFS

pool 以增加ZFS

磁區容量時,新增的ZFS支援虛擬裝置,被稱之為vdev,。vdev可以是單一個硬碟,stripe(串接),

mirror(鏡像),

a RAIDZ1, RAIDZ2, or a

RAIDZ3.。vdev一經建立,將無法新增更多磁碟到該vdev中。此外,你可以用相同型式的現存vdev

串接

新vdev(及它的磁碟)去增加ZFS

pool的整體容量。換言之,當你擴充

某一 ZFS

磁區時,相當於串接類似的vdev。在此可見到一些例子。

- 擴充ZFS stripe,增加一個或多個磁碟。既然未使用複聯,你不須增加相同數量的磁碟到現存的 stripe中。

- 擴充ZFS mirror,增加相同數量的裝置。最終的 striped mirror 是 RAID 10。例如,你擁有 10個磁碟,你最初用 2顆磁碟建立 mirror,擴充此裝置係藉由兩個磁碟一組的 mirror ,再逐一擴充3次直到10顆磁碟均已增加為止。

- 擴充3個磁碟的 RAIDZ1,增加3個附加磁碟,其結果為 RAIDZ+0,類似硬體控制 RAID 50

- 擴充 RAIDZ2最小需要4個附加硬碟。其結果如同RAIDZ2+0,類似硬體控制 RAID 60

若你試圖增加不正確的磁碟數量到現存

vdev中,將顯現錯誤訊息,標示你所需磁碟的數量。你將需要正確數量的磁碟方可

繼續執行。

建立 ZFS Datasets

已存在的磁區可分割成資料集。以資料集的為基礎單位可分別設定權限,壓縮,重複數據刪除和配額,並允許更精確地控制存儲資料的存取。資料集類似一個文件夾,你可以設置權限,也像是一個檔案系統,你可以設置屬性(如配額、壓縮及建立快照)。

註:

ZFS

提供厚配置使用配額和自動精簡配置,使用預留空間。參閱

Figure

6.3i畫面。而

Table

6.3b則為各選項的總覽表。

dataset

一經建立即可點擊該

dataset

並選擇Create

ZFS Dataset,藉此建立巢狀的dataset

或於某一dataset中的

dataset。亦可在dataset

中建立zvol

。建立datasets

時,雙按

使用Create

ZFS Dataset 選項對擴充磁區或dataset。

如果於磁區上建立資料集有誤時,請單擊“關閉所有現有資料集

“後續資料建立將自動停止。

Figure

6.3i: 建立ZFS

Dataset

Table

6.3d 為建立

ZFS

dataset可用選項一覽表。某些設定僅適用於進階模式

。欲參閱這些設定,可以按下 進階 Mode

button 或於系統中預先勾選“Show

advanced fields by default” 選項(在

系統 → 設定 → 進階)

事先顯示該選項。這些屬性亦可於dataset

建立

後於 儲存 → 磁區 → 檢視磁區.中變更之

Table

6.3d: 資料集選項

Setting

|

Value

|

Description

|

|---|---|---|

Dataset

Name

|

string

|

必填選項

|

Compression

Level

|

drop-down

menu

|

參閱 Compression 中對可用演算法的比較

|

Enable

atime

|

Inherit,

On, or Off

|

當讀取文件時是否更新文件的存取時間,讀取時將此屬性設定為“off”

可避免產生讀取日誌流量並顯著提升效能

|

Quota

for thisdataset

|

integer

|

預設0

為不限制配額,亦可指定為

M

(megabyte), G (gigabyte), or T (terabyte) 20G 代表配額

20

GB,亦可使用小數點標示之(e.g. 2.8G)

|

Quota

for thisdataset

and children

|

integer

|

預設0

為不限制配額,亦可指定為

M

(megabyte), G (gigabyte), or T (terabyte) 20G 代表配額

20

GB

|

Reserved

space for this dataset

|

integer

|

預設0

為不限制配額,亦可指定為

M

(megabyte), G (gigabyte), or T (terabyte) 20G 代表配額

20

GB

|

Reserved

space for this dataset

and children

|

integer

|

預設0

為不限制配額,亦可指定為

M

(megabyte), G (gigabyte), or T (terabyte) 20G 代表配額

20

GB

|

ZFS

Deduplication

|

drop-down

menu

|

|

| Record Size | drop-down menu |

僅用於進階模式;雖然ZFS會自動動態地適應記錄大小以適應資料,如果資料具有固定大小(如資料庫),設置記錄大小可能會導致更好的性能

|

ZFS的重複數據刪除選項提示警告,若啟動dedup可能大幅影響效能,應採壓縮方案替代之。勾選

deduplication選項前,首先閱讀 ZFS

Overview 中的重複資料刪除

章節。此文件對重複資料刪除 中價值 對 成本

的考提供良好敘述。

除非擁有大量

RAM與大量的

duplicate

data,切毋變更

預設deduplication

值為"Off"

的設定。

dedup

tables 使用

deduplication

期間

每 1TB

資料需

8GB

的RAM

。基於效能的理由,考量使用壓縮比啟用此選項更洽當。

若重複資料刪除技術變更為啟動(On)時,重覆的資料將同步移除。此結果是僅有唯一性的資料被儲存且普通的組件被分散存諸多檔案中,若變更為

Verify

驗證,當兩個區塊具有相同的簽章,ZFS將一個位元一個位元的比較

以確保該區塊的內容一致,由於雜湊碰撞相當罕見,通常不值得犧牲效能實施驗證。

註:

重複資料刪除一經啟用,唯一停用方式係於 Shell使用

zfs

set dedup=off dataset_name 指令。此外,任何已經採用 重複資料刪除

儲存的資料將不會取消 重複資料刪除的屬性,只有新存儲的數據將無法使用 重複資料刪除。刪除現有的 重複資料刪除的唯一方法是複製所有dataset的資料,該屬性設置為off,然後將資料複製回存。或者,建立一個新的dataset與ZFS的重複數據刪除左側為停用,將資料複製到新的dataset,並銷毀原始資料集。壓縮

大多數媒體(e.g.

.mp3, .mp4, .avi)業經壓縮,意即是對此類檔案壓縮除增加CPU利用率外並無助益。但若為raw

.wav rips of CDs or .vob rips of

DVDs,使用壓縮則對效能上有相當助益。選擇的壓縮型式時,則需要考量的壓縮量與效能取得平衡。支援下列壓縮演算法

- lz4:推薦的壓縮方法,因為它允許以接近即時的速度進行datasets 壓縮。

- gzip:從等級1到9不等,其中:gzip 最快的(1級),有最快的壓縮速度; gzip最高(9級)提供了最大的壓縮率,但對效能影響則為最高

- zle:可提供快速和簡單的算法來消除零的執行。

- lzjb: 在最佳化性能的同時,提供不錯的資料壓縮。

若保留 Inherit的預設值,將繼承來自父層的設定,除非父層dataset

設定已變更,預設壓縮等級為 lz4

若選用

Off

,

該dataset

將不壓縮。

Creating a zvol

建立

zvol,選用一個現存的ZFS

磁區或

dataset

→ create zvol 可見到

Figure

6.3j的畫面

Figure

6.3j: creating zvol

設定選項描述於

Table

6.3e。某些設定僅適用於進階模式

。欲參閱這些設定,可以按下 進階 Mode

button 或於系統中預先勾選“Show

advanced fields by default” 選項(在

系統 → 設定 → 進階)

事先顯示該選項。這些屬性亦可於dataset

建立

後於 儲存 → 磁區 → View

Volumes.中變更之

Table

6.3e: zvol 組態設定選項

| Setting | Value | Description |

| ZFS Volume Name | string |

為zvol命名

|

| Size for this zvol | integer |

指定大小例如

10G

|

| Compression Level | drop-down menu |

預設為

Inherit,將使用與現存的資源池相同的壓縮格式

|

| Sparse volume | checkbox |

用於提供自動精簡配置,即便勾選此選項,當資源池空間低水位時寫入將失敗。

|

| Block size | integer |

僅適用於進階模式,預設為8kb

正確大小由

12b 到

128kb

以2

的倍數增加之;可被設定為符合iSCSI目標內 檔案的區塊格式。

|

檢視磁碟

儲存

→ 磁區 → 檢視磁碟 允許你檢視

FreeNAS®

系統所辨識出的全部磁碟。

Figure

6.3k 為其中的範例

Figure

6.3k: 檢視磁碟

對個別裝置,描述於Table

6.3f 的現行設定已被顯示,按下磁碟的入口然後它的Edit

button 即可用於變更設定。

按下磁碟入口同時亦將顯示它的

Wipe

button(可用於清空磁碟並同時提供清除狀態進度)。棄置磁碟前使用此選項。

檢視磁區

如按下

儲存 → 磁區 → 檢視磁區 可預覽並進一歩組建已存在ZFS

datasets,及

zvols.,Figure

6.3i 畫面示範一個ZFS磁區擁有2個dataset及1個

zvol

Figure

6.3l: 檢視磁區

右頁框上方的圖示允許你使用: ZFS

Volume Manager, UFS

Volume Manager, Import

Volume, Auto

Import Volume,

and View

Disks.。若系統為具有多重路徑能力

的硬體,額外的按鈕將附加 View

Multipaths功能

若按下ZFS

volume 的進入點,ZFS磁區有8項相關功能圖示,由左至右,這些選項允許你做:

- Detach volumn缷載磁區:允許您自系統移除磁區或刪除磁區內容前可先行缷載(也稱為ZFS出口),當你點擊按鈕後,瑩幕將彈出Figure 6.3m 畫面訊息,該畫面將顯示目前使用空間,提供勾選選項"Mark the disks as new (destroy data)"“標記為新的磁碟(破壞數據),如果磁區有任何分享區,將提示復行確認,如果欲確定刪除,瀏覽器會變成紅色,同時提示相關作業將造成資料無法讀取。

若不勾選

mark

the disks as

new選項,該磁區將匯出(僅為ZFS磁區)。意即該磁區內容並未清除且可於後續使用時直接再匯入。若移置ZFS格式的裝置到另一個系統,請先執行 export 匯出作業。該作業系統即刷新磁碟之資料,寫入資料到磁碟中並標示已完成匯出,然後從系統中刪除所有的已知的資源池。若勾選

mark

the disks as new選項該磁區及所屬全部資料、資料集及zvol將被摧毀且底層磁碟將回復到初始狀態。

Figure

6.3m: 缷載或刪除

磁區

2.檢查磁區是否正常:如何排程更詳細的描述請參閱 ZFS

Scrubs。此按鈕可讓您手動啟動檢查磁區是否正常。清理過程中I

/ O讀取頻繁,對效能產生負面影響,這意味著,你不應該於系統繁忙時啟用。如需取消此作業請按“取消”按鈕。

註:如取消檢查磁區是否正常,已執行作業無法取消,但可停止下一個動作

3.編輯

ZFS

選項:允許編輯磁區的壓縮級別,atime的設定,資料集配額和配額預留空間。啟用的磁區或資料集若已內含壓縮資料,該文件不予壓縮,直到檔案重新寫入時則重新依選定方式壓縮。

6. 變更權限:用於輯編磁區子目錄區的使用者、群組、UNIX

rwx 權限,ACL

型式及是否設定遞迴式權限。

8.磁區狀態: 圖6.3n的例子可見,瑩幕顯示設備名稱和每個ZFS資源池現況與任何讀,寫或校驗錯誤資訊。亦可標示出最後一次 ZFS

scrub

的狀態。若按下某一裝置的進入點,按鈕將顯示編輯該裝備的選項(

Figure

6.3n),缷載裝置或更換裝置 replace

the device。

Figure

6.3n: 磁區狀態

若於磁區狀態中按下“管理磁碟”

按鈕,可見到如 Figure

6.3o 畫面

Figure

6.3o: 管理磁碟

Table

6.3d: 磁碟選項

Setting

|

Value

|

Description

|

|---|---|---|

Name

|

string

|

FreeBSD裝置名稱(唯讀不可更改)

|

Serial

|

string

|

磁碟序號(唯讀不可更改)

|

Description

|

string

|

選項

|

HDD

Standby

|

drop-down

menu

|

標示若閒置時間幾分鐘後進入待機模式,以節省能源,(以分鐘計)

|

Advanced

Power Management

|

drop-down

menu

|

預設為停用,可由此選項中設定電源管理

|

Acoustic

Level

|

drop-down

menu

|

|

Enable S.M.A.R.T

|

checkbox

|

|

S.M.A.R.T.

extra options

|

string

|

smartctl(8) 選項

|

註:FreeNAS®8.3.1版以前,凡HDD

待機,

進階電源管理,及噪音位準設定等,均需重新開機變更,而FreeNAS®8.3.1版起變更後即可啟用新設定,不需重新開機。

ZFS資料集僅有5個檢查磁區是否正常磁區圖示,建立ZFS磁區和磁區狀態按鈕亦僅適用於該磁區。資料集中磁區按鈕改以摧毀資料集按鈕取代之。如果你按下“Destroy

Dataset”按鈕,瀏覽器將變為紅色,標示此為破壞性的行動。並彈出警告訊息警告:摧毀資料集,將刪除該資料集中所有文件及快照

加密磁區的管理關鍵

Figure

6.3p: 關聯於ZFS

加密磁區中的加密圖示

此類圖示可用於

建立/變更

通關密語:單擊圖示

設定並確認此通關密語為該GELI的加密金鑰。切記密碼,無密碼便無法重新導入加密磁區。換言之,如未建立密碼,或者您忘記通關密語,將無法存取磁區中的資料。USB隨身碟失效的例子中,你將需要全新安裝一個新的USB記憶隨身碟並重新導入現有資源池中,或將舊的硬體系統移動到一個新的系統時,磁碟的實體抹除。嚴密保護此一密碼,因為任何人凡擁有此密碼即可重新導入加密磁區,故而,挫敗的首要原因即是磁碟加密所造成的誤失。

當你點擊圖示,將顯示紅色警示:記住增加一個新的回復金錀,以備先前回復金錀無效時預備之用。設置一個通關密語,一旦現有的密鑰失效時,立即增加回復密鑰

單擊 新增還原金錀

按鈕,建立新的回復金錀。通關密語一經設定,該圖示的名稱將變更為變更通關密語。

下載金錀:按下圖示後可下載

GELI加密金錀的備份,既然GELI加密金錀與FreeNAS®環境資料庫彼此分離。在此強烈建議金錀應予備份。若金錀遺失或毀損且無備用金錀,磁碟中資料將無法讀取。

新增還原金錀:產生一個新的還原金錀並提示該還原金錀下載備份區的(儲存)位置。若通關密語遺失時此復原金錀即可以採用。通關密語變更時

即刻

新增復原金錀。

加密復原金錀:製作新的GELI的加密金鑰。一般情況下,僅為管理員懷疑現行金錀可能受損時的執行選項。此行動也會將目前使用通關密語移除。

新增還原金錀:產生一組新的還原金錀然後提示一個位置來下載還原金鑰的備份副本。該金錀可用於當通關密碼忘記時之用。當通關密語變更時應立即新增還原金錀。

移除還原金錀:通常情況下,這僅僅是當管理員懷疑,當前的還原金錀可能會受到影響。立即建立一個新的密碼和還原密鑰。

存取FreeNAS®管理GUI

時系統將個別提示此類圖示

權限設定

設定權限為磁區配置要項。圖形化的管理界面可設定磁區或資料集的初始權限,以供分享之用。一旦分享區可用,應當由客端操作系統進行微調,並由客戶端使用者建立文件和目錄的權限。

分享:含幾種類型的權限方案配置範例。本章節在 Sharing 內容中提供一個設定權限全覽式畫面

一旦建立磁區或資料集,會列出掛載點儲存媒體的名稱於

儲存 → 磁區

→ 檢視磁區。如果對 特定的磁區/資料集

單擊“變更權限”圖示,會看到Figure

6.3o 中所示的畫面。Table

6.3e 為該畫面選項的總表。

Figure

6.3q: 磁區

or

Dataset 權限變更

TTable

6.3e: 變更權限選項

| Setting | Value | Description |

| Owner (user) | drop-down menu |

使用者可控制磁區/資料集

(採用手動建立或從Active

Directory或LDAP導入的使用者

將出現在下拉選單中)

|

| Owner (group) | drop-down menu |

群組使用者可控制磁區/資料集

(採用手動建立或從Active

Directory或LDAP導入的群組使用者

將出現在下拉選單中)

|

| Mode | checkboxes |

對UNIX使用者、群組及其它群組

勾選授權使用者

|

| Type of ACL | bullet selection |

Unix和Windows

ACL是互斥選項的,意即必須配合分享類型選擇正確型別,詳見下文

|

| Set permission recursively | checkbox |

如勾選,該權限設定適用於磁區或資料集之子目錄,如果資料已經存在於磁區/資料集,建議變更客戶端遞迴權限,以防止FreeNAS的系統效能上的遲延

|

當你有疑問時,或者如果你網路上的作業系統為混合型,且多數客端使用者熟悉Unix的ACL時,請選用

Unix

ACLs。而Windows

ACL適用於僅由Windows客端組成的網路,亦為Active

Directory網域管理的首選。Windows

ACL權限,增加由Unix的ACL提供的一個超集。雖然Windows客戶端也可解譯Unix的ACL,但無法由Unix的ACL獲取額外的權限的設定能力。

如變更ACL類型,並不需重建磁區。也就是說,現有的資料並不會遺失,唯不同的存取控制列表(ACLs)將會變更。不過,如果你的Windows

ACL的Unix的ACL,擴充的Windows

ACL的權限將被從現有文件中刪除。

當你選用

Windows

ACLs, Mode 將變成灰色如同它僅適用於

Unix

權限。Windows

ACLs 總是將新的文件和目錄依預設配置予以設定。而Windows客戶端則可應用微調來修訂需求權限。

多重路徑綜觀

多重路徑硬體具有容錯能力,古典的雙重SAS

expander 備份計畫,或外部的JBOD即是一個列子。即使磁碟I/

O路徑上出現失效作業,資料仍可持續寫入NAS中。

FreeNAS®自動檢測

主動/主動,主動/被動

具多重路徑能力的硬體。任何具有多重路徑硬體

一經偵測發現,將被放置在多重路徑單位的上層設備中。該環境組態將顯示於

儲存 → 磁區 → 檢視

Multipaths

,參閱範例

Figure

6.3p,註,不具有多重路徑能力的硬體裝置並不會出現在

儲存 → 磁區 樹狀顯示區

Figure

6.3r: Viewing Multipaths

Figure

6.3r提供一擁有

SAS

ZIL 及

SAS硬體的範例系統。該

ZIL裝置

active/active寫入能力,因此該硬體裝置擁有

active/read

能力。

驅動器損毀時的更換

如使任意來自複聯RAID

磁碟,當裝置失效時應盡可能的立即更換以修復RAID

降級的狀況。更換硬體時系統應否重新開機,端賴硬體能力而定。具AHCI

能力硬體不需重新開機。

註: a

stripe (RAID0)並未提供複聯能力,如任一磁碟損壞,你將需要重建磁區並由備份區中重新回存資料。

實體移除失效裝置前

,請前往 儲存 → 磁區 → 檢視磁區 → 磁區狀態

然後標定出失效裝置。一旦於GUI中標定出失效裝置,請依序執行以上步驟

- 若該磁碟為 ZFS 格式,按下 "Offline" 離線 按鈕變更狀態到 離線。此步驟對防止由ZFS資源池移除裝置所導致交換磁區之問題適切需求作為並預防swap 問題。如硬體支援熱插拔磁碟,拉出磁碟然後進入步驟3。若此處沒有"Offline" 按鈕而僅有"Replace" 按鈕,表示該磁碟已離線且可以安全的跳過此步驟

註:若離線指令執行過程中發生"disk

offline failed - no valid replicas" 訊息,應先檢查磁區是否正常zfs

磁區(

該檢查磁區是否正常磁區按鈕於

儲存 → 磁區 → 檢視磁區.)中。一旦檢查磁區是否正常完成,再執行離線作業乙次

- 若硬體不具有 ACHI 能力,為更換磁碟應將系統停機。完成後,回到 GUI然後配置 離線磁碟。

- 一旦磁碟進入離線狀態,按下磁碟更換鈕,由下拉式選單中選取更換磁碟然後再按下更換磁碟鈕。若該磁碟已新增至ZFS資源池它會開始重新同步,可於命令列 Shell 使用 zpool status 指令以監督同步執行現況。

- 如更換之磁碟重新列示於,使用“離線”按鈕,從清單中刪除磁碟

在Figure

6.3s的範例中,假定名為volum1的磁區中有某一個磁碟失效將改由ada2

磁碟更換之。

Figure

6.3s: 驅動器損毀時的更換

Replacing a Failed Drive in an Encrypted Pool

If

the ZFS pool is encrypted, additional steps are needed when replacing

a failed drive.

First,

make sure that a passphrase

has been set before attempting

to replace the failed drive. Then, follow the steps 1 and 2 as

described above. During step 3, you will be prompted to input the

passphrase for the pool. Wait until the resilvering is complete.

Next,

restore the encryption keys to the pool. If the following

additional steps are not performed before the next reboot, you may

lose access to the pool permanently.

如果ZFS

pool 已加密,更換發生故障的驅動器時需要額外的步驟。

首先,請確保通關密語已於嘗試更換故障驅動器之前被設定。然後,按照上述步驟1和2。在步驟3中,你將被提示對該pool

輸入

密碼。靜候並等到重新同步完成為止。

接下來,還原加密密碼到pool中。如果在下一次重新啟動之前,不執行以下附加步驟,你可能會永久的失去存取pool的機會

。

1.高亮度顯包含剛剛更換的磁碟的的pool,然按下

GUI中的“加密重製”按鈕。你將需要輸入root的密碼。

2.高亮度顯示包含剛剛更換的磁碟pool,然後按下“建立通關密語”按鈕,然後輸入新的密碼。如果需要,您可以重複使用舊密碼。

3.高亮度顯示包含剛剛更換的磁碟pool

然後按下"下載金鑰"按鈕

以保存新的加密金鑰“。由於舊的金鑰已失效,任何舊金鑰可以安全地丟棄。

4.高亮度顯示包含剛剛更換的磁碟pool然後按下"新增還原金鑰"按鈕以保存新的還原金鑰。舊的還原金鑰將已失效,所以可以安全地丟棄。

移除日誌或快取裝置

如果您已新增任何日誌或快取裝置,這些裝置也將出現在

儲存→磁區→檢視磁區→磁區狀態。如果您按下該裝置,您可以使用它的“更換”按鈕,以取代上述裝置,或按下“移除”按鈕,移除裝置。

如果pool

正在運行ZFSv15且一個非鏡像日誌裝置出現故障,即使更換或拆除,pool亦無法復原,該pool必須重建並從備份中還原資料。對於其他的ZFS版本,移除或更換日誌裝置將失去在那些尚未被寫入該設備的任何資料(通常會損失最後幾秒鐘的寫入資料)。

移除或更換快取裝置不會導致任何資料遺失,唯或許將對讀取性能產生影響直到設備更換為止。

更換驅動器(磁碟)以擴增 ZFS pool

然而,如果你沒有開放的驅動器埠或添加SAS/

SATA

HBA卡的能力,此選項未必可用。在這種情況下,你可以每次將一個磁碟更換為更大的磁碟,等待同步過程,將新磁碟匯入資料資源池,然後逐一重複執行,直到所有的硬碟完成替換為止。此作業過程緩慢且系統將處於降級狀態。一旦失敗亦可能招致災難性的結果,除非系統有一個可靠的備份

不要嘗試這種方法。

註:此法需使用

ZFS

自動擴充屬性。此屬性為

FreeNAS®

version 8.2.0版的新增功能。若使用較早版本應昇級至該版方可使用。

本例中

檢查名為Vol1的ZFS磁區

。

zpool get all Vol1 NAME PROPERTY VALUE SOURCE Vol1 size 4.53T - Vol1 capacity 31% - Vol1 altroot /mnt local Vol1 health ONLINE - Vol1 guid 8068631824452460057 default Vol1 version 28 default Vol1 bootfs - default Vol1 delegation on default Vol1 autoreplace off default Vol1 cachefile /data/zfs/zpool.cache local Vol1 failmode wait default Vol1 listsnapshots off default Vol1 autoexpand on local Vol1 dedupditto 0 default Vol1 dedupratio 1.00x - Vol1 free 3.12T - Vol1 allocated 1.41T - Vol1 readonly off - Vol1 comment - default

若未啟動,請指定ZFS名稱啟動之。

zpool

set autoexpand=on Vol1

重複使用

zpool

get all Vol1以驗證自動擴充啟用否。

一次更換一個磁碟並在更換下一個磁碟前等待安裝中的磁碟完成同步化,然後再更換下一個磁碟。一旦所有的磁碟更換並重新完成同步化,即可見到資源池增加的容量了。

驅動器更換後啟用ZFS pool的擴增

驗證如前一節中所描述自動展開設定。然後用下列的指令將每個驅動器重新上線,為每一個在ZFS

pool中的磁碟更換磁區名稱及GPT的ID:

zpool online -e Vol1 gptid/xxx

在此建議開始更換磁碟前應啟用自動擴充屬性。若該屬性在更換某些或全部磁碟前未事先啟用,

ZFS容量的擴充將需要額外的設定。

為取得該磁碟的 GPT

ID 資訊可使用

glabel

status or zpool

status [Pool_Name]

(亦可用於任一磁碟故障或正執行重新同步時)。

zpool status Vol1 pool: Vol1 state: ONLINE scan: scrub repaired 0 in 16h24m with 0 errors on Sun Mar 10 17:24:20 2013 config: NAME STATE READ WRITE CKSUM Vol1 ONLINE 0 0 0 raidz1-0 ONLINE 0 0 0 gptid/d5ed48a4-634a-11e2-963c-00e081740bfe ONLINE 0 0 0 gptid/03121538-62d9-11e2-99bd-00e081740bfe ONLINE 0 0 0 gptid/252754e1-6266-11e2-8088-00e081740bfe ONLINE 0 0 0 gptid/9092045a-601d-11e2-892e-00e081740bfe ONLINE 0 0 0 gptid/670e35bc-5f9a-11e2-92ca-00e081740bfe ONLINE 0 0 0 errors: No known data errors

所有磁碟上線之後,鍵入zpool

status 。若磁碟正執行重新同步,請靜候該過程執行完成。

下一步,匯出然後匯入該資源池

zpool export Vol1 zpool import -R /mnt Vol1

一旦匯入完成,所有磁碟空間即可使用。驗證確認增加的大小

zpool list Vol1 NAME SIZE ALLOC FREE CAP DEDUP HEALTH ALTROOT Vol1 9.06T 1.41T 7.24T 31% 1.00x ONLINE /mnt

若無法見到額外的空間,或許需要對每一列示於 zpool

status的磁碟執行

zpool

online -e <pool> <device> 了。

拆解一個鏡像ZFS

資源池...

ZFSv28提供分割鏡像資源池的能力,可於原始ZFS磁區中分離一個或多個磁碟於另一個系統上建立另一個完全相同的ZFS磁區。

註

zpool分割僅作用於鏡像ZFS

磁區中。

本例中,名為

test

ZFS鏡像

包含3個磁碟

zpool status pool: test state: ONLINE scan: resilvered 568K in 0h0m with 0 errors on Wed Jul 6 16:10:58 2011 config: NAME STATE READ WRITE CKSUM test ONLINE 0 0 0 mirror-0 ONLINE 0 0 0 da1 ONLINE 0 0 0 da0 ONLINE 0 0 0 da4 ONLINE 0 0 0

以下的指令從現有的三個磁碟鏡像測試一個新的名為 migrant

ZFS磁區包含一個磁碟(da4)。磁碟da0和da1保持於test

zpool split test migrant da4

此時,da4可以實體刪除且安裝到新系統,亦如同匯出新建立的資源池一般。

一經實際安裝後,在新系統上匯入相同的資源池:

zpool import migrant

這使得ZFS磁區 migrant

可用於單一磁碟。要知道,隨著複製工作新的資源池將被掛載於在舊資源池掛載點上,若原掛載點已設定其屬性,相關的屬性亦將完整移植到新的資源池中

確認新資源池的狀態

zpool status pool: migrant state: ONLINE scan: resilvered 568K in 0h0m with 0 errors on Wed Jul 6 16:10:58 2011 config: NAME STATE READ WRITE CKSUM migrant ONLINE 0 0 0 da4 ONLINE 0 0 0 errors: No known data errors

初始系統狀態大致如下:

zpool status pool: test state: ONLINE scan: resilvered 568K in 0h0m with 0 errors on Wed Jul 6 16:10:58 2011 config: NAME STATE READ WRITE CKSUM test ONLINE 0 0 0 mirror-0 ONLINE 0 0 0 da1 ONLINE 0 0 0 da0 ONLINE 0 0 0 errors: No known data errors

At

this point, it is recommended to add disks to create a full mirror

set. This example adds two disks named da2 and da3:

此時系統建議增加硬碟以建立完整的鏡像集。本例中新增2個名為

da2及da3的硬碟。

zpool attach migrant da4 da2 zpool attach migrant da4 da3

The migrant volume

now looks like this:

zpool status pool: migrant state: ONLINE scan: resilvered 572K in 0h0m with 0 errors on Wed Jul 6 16:43:27 2011 config: NAME STATE READ WRITE CKSUM migrant ONLINE 0 0 0 mirror-0 ONLINE 0 0 0 da4 ONLINE 0 0 0 da2 ONLINE 0 0 0 da3 ONLINE 0 0 0

現在新系統已經被複製,可以卸離 da4 然後安裝備份到最初系統中。在實體移除硬碟前,於新系統上執行以下指令

zpool detach migrant da4

一旦該磁碟被實體重新安裝,於最初系統執行以下指令

zpool attach orig da0 da4

如果你需要建立一個新的複製,記得先刪除舊的複製:

zpool destroy migrant

沒有留言:

張貼留言